三星 SAIL 蒙特利尔实验室的研究人员近日推出了一种名为**“微型递归模型”(TRM)的新型 AI 架构。这款模型参数仅有 700万个,远小于动辄数十亿参数的最小型语言模型(LLM),却在数独和 ARC-AGI 测试**等复杂的结构化推理任务中,表现出惊人的效率和卓越的性能,成功超越了包括 Gemini2.5Pro 和 Claude3.7 在内的多个大型语言模型。

递归推理核心机制:紧密重复的校正循环

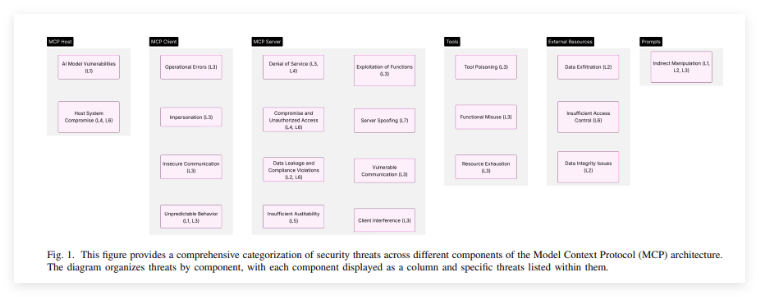

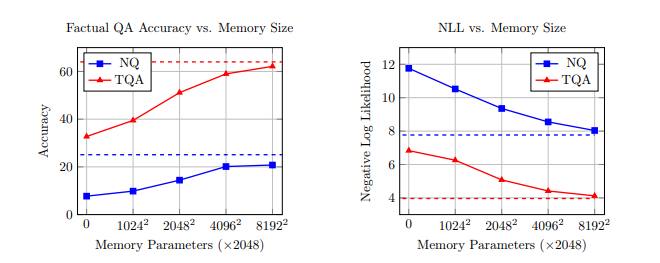

根据研究报告《少即是多:基于微型网络的递归推理》,TRM 在ARC-AGI-1上的准确率达到45%,在ARC-AGI-2上的准确率达到8% ,其表现优于规模更大的模型,包括 o3-mini-high(ARC-AGI-2上的准确率3.0%)、Gemini2.5Pro(4.9%)、DeepSeek R1(1.3%)和 Claude3.7(0.7%)。作者表示,TRM 仅使用不到大多数大型模型所用参数的0.01% 即可实现这一目标。Grok-4-thinking(16.0%)和 Grok-4-Heavy(29.4%)等更专业的系统仍然处于领先地位。

作者强调,TRM 仅使用了不到大多数大型模型所用参数的 0.01%,便在 ARC-AGI-1和 ARC-AGI-2上分别取得了 45% 和 8% 的准确率,优于多种更大规模的通用模型。在其他基准测试中,TRM 同样表现出色,将 Sudoku-Extreme 的准确率从55.0% 提升至 87.4%,Maze-Hard 的准确率从74.5% 提升至 85.3%。

研究意义与局限性

TRM 的研究结果证明了小型、有针对性的模型在处理狭窄、结构化推理任务时的巨大潜力,它能够通过逐步改进和数据增强实现极高的效率。研究还表明,针对特定数据集进行架构选择(如在固定大小网格中使用简单的 MLP 而非注意力机制)是成功的关键。

然而,TRM 并非通用 LLM 的替代品。它运行在定义明确的网格问题中,并且不是一个生成系统,因此不适用于开放式、基于文本或多模态的通用任务。

相反,TRM 代表了推理任务中一个极具前景的构建模块,展示了计算效率与复杂推理能力平衡的新方向,并可能在未来拓展其应用领域。独立复制和测试仍在进行中。

TRM 的出现强调了在 AI 领域中,架构创新与算法优化可能比单纯追求模型规模更重要。您认为这种“小而精”的 AI 模型未来最可能率先在哪些垂直领域实现大规模应用?

.png)

960x540.jpg)

发评论,每天都得现金奖励!超多礼品等你来拿

登录 在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则