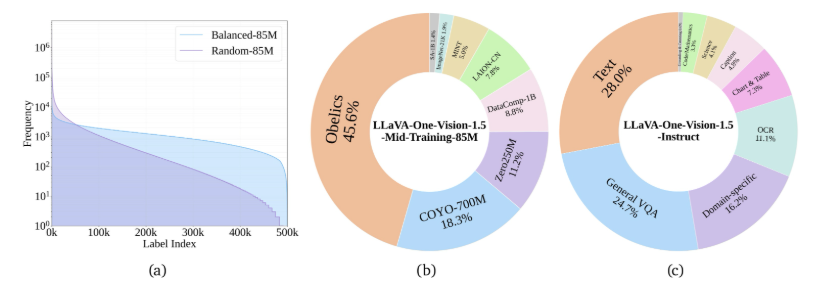

在近期的 AI 技术进展中,字节跳动与多所高校的研究团队合作,将先进的视觉语言模型 LLaVA 与分割模型 SAM-2结合,推出了名为 Sa2VA 的新模型。这一创新模型不仅能够理解视频内容,还可以根据用户指令精确追踪和分割视频中的角色和物体。

LLaVA 作为一种开源视觉语言模型,擅长于视频的宏观叙事和内容理解,但在细节指示方面则显得力不从心。而 SAM-2则是一种出色的图像分割专家,能够识别和分割图像中的物体,但缺乏语言理解能力。为了弥补彼此的不足,Sa2VA 通过一个简单而高效的 “暗号” 系统,将这两种模型有效结合。

Sa2VA 的架构可以被视作一个双核处理器:一核负责语言理解与对话,另一核负责视频分割与跟踪。当用户输入指令时,Sa2VA 生成特定的指令 token,传递给 SAM-2以进行具体的分割操作。通过这一设计,两个模块在各自领域内发挥专长,并能进行有效的反馈学习,进而不断提升整体性能。

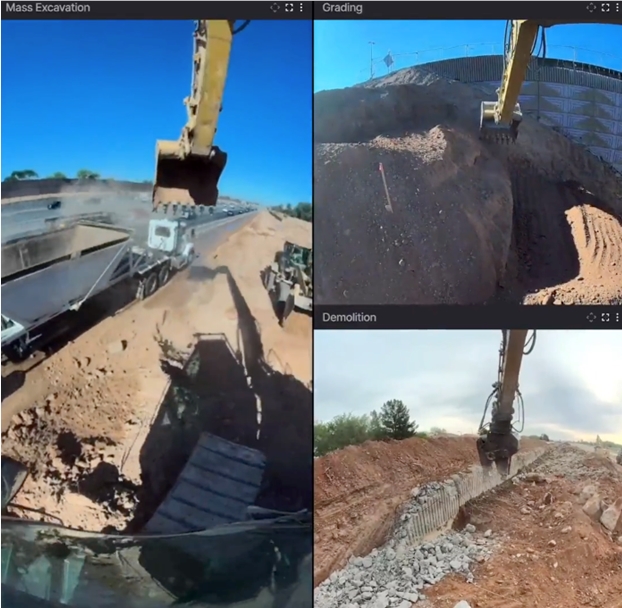

研究团队还为 Sa2VA 设计了多任务联合训练课程,以增强其在图像和视频理解方面的能力。在多项公开测试中,Sa2VA 展现了出色的性能,尤其在视频指代表达分割任务中表现尤为亮眼。它不仅能在复杂的真实场景中实现精准的分割,还能在视频中实时跟踪目标对象,显示出强大的动态处理能力。

此外,字节跳动还开放了 Sa2VA 的多种版本和训练工具,鼓励开发者进行研究和应用。这一举措为 AI 领域的研究人员和开发者提供了丰富的资源,推动了多模态 AI 技术的发展。

项目:

https://lxtgh.github.io/project/sa2va/

https://github.com/bytedance/Sa2VA

划重点:

– 🎥 Sa2VA 是字节跳动推出的新模型,结合了 LLaVA 与 SAM-2的优点,实现了视频内容的理解与分割。

– 🔗 该模型通过 “暗号” 系统有效连接语言理解与图像分割,提升了交互能力。

– 🌍 Sa2VA 的开放资源为开发者提供了丰富的工具,促进了多模态 AI 技术的研究与应用。

.png)

960x540.jpg)

发评论,每天都得现金奖励!超多礼品等你来拿

登录 在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则