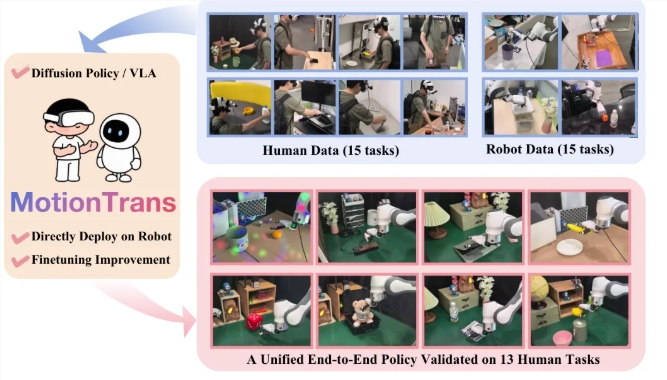

近日,清华大学、北京大学、上海交通大学和武汉大学等高校联合发布了一种名为 MotionTrans 的人机协同训练框架。这一框架的创新之处在于,让机器人能够在没有任何示范的情况下,仅通过观察人类的动作,学习和执行新的技能。这标志着机器人学习领域的一次重大突破。

传统的机器人训练需要大量的真实演示数据,收集这些数据的过程耗时且成本高昂。例如,教机器人如何拧瓶盖,需要反复操作并记录每一个细节。而现在,MotionTrans 通过虚拟现实(VR)设备,能够捕捉人类的精细手部动作数据,从而为机器人提供学习的基础。

在 MotionTrans 的实施过程中,研究人员使用便携式 VR 设备,任何人都可以随时参与数据录制。系统不仅记录佩戴者的手部关键点,还同步拍摄第一人称视角的视频,这样确保了数据的高质量和丰富性。收集完成后,团队建立了一个包含3,213个演示的数据集,涵盖了多种人类与机器人任务。

核心的技术在于将人类的动作数据转化为机器人可理解的格式。研究者们通过优化技术将人类的手部动作精确映射到机器人的关节角度,这样机器人便能够在真实环境中执行人类的动作。此外,为了适应机器人的工作特点,研究团队还进行了速度和舒适区域的调整,以确保机器人的安全与稳定。

这一创新框架的推出,意味着机器人能够通过模仿人类的自然动作,实现更高效的技能学习,为未来的人机协作奠定了基础。

github:https://github.com/michaelyuancb/motiontrans

划重点:

🦾 研究团队推出 MotionTrans 框架,使机器人可以零样本学习新技能。

👾 通过 VR 设备收集人类手部动作数据,构建丰富的训练数据集。

🔧 人类动作数据被转化为机器人语言,实现更高效的技能转移。

.png)

960x540.jpg)

发评论,每天都得现金奖励!超多礼品等你来拿

登录 在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则