12月4日,北京智源人工智能研究院正式发布新一代多模态大模型Emu3.5,被誉为“真正理解物理世界的AI”。与以往图像、视频、文本模型各自为战不同,Emu3.5首次实现“世界级统一建模”,让AI从“会画画、会写文”进化到真正“懂世界”。

传统AI的致命短板:不懂物理、不懂因果

过去绝大多数图像生成模型虽然画得逼真,却严重缺乏对真实世界规律的理解:物体不会无缘无故飞起来,重力、碰撞、运动轨迹对它们来说完全是“黑箱”。即使是顶级视频生成模型,也常常出现动作突变、逻辑断裂的现象,根本原因是:它们学的只是“表面的像素”,而不是“世界的运行规则”。

Emu3.5的核心突破:预测“世界下一秒”

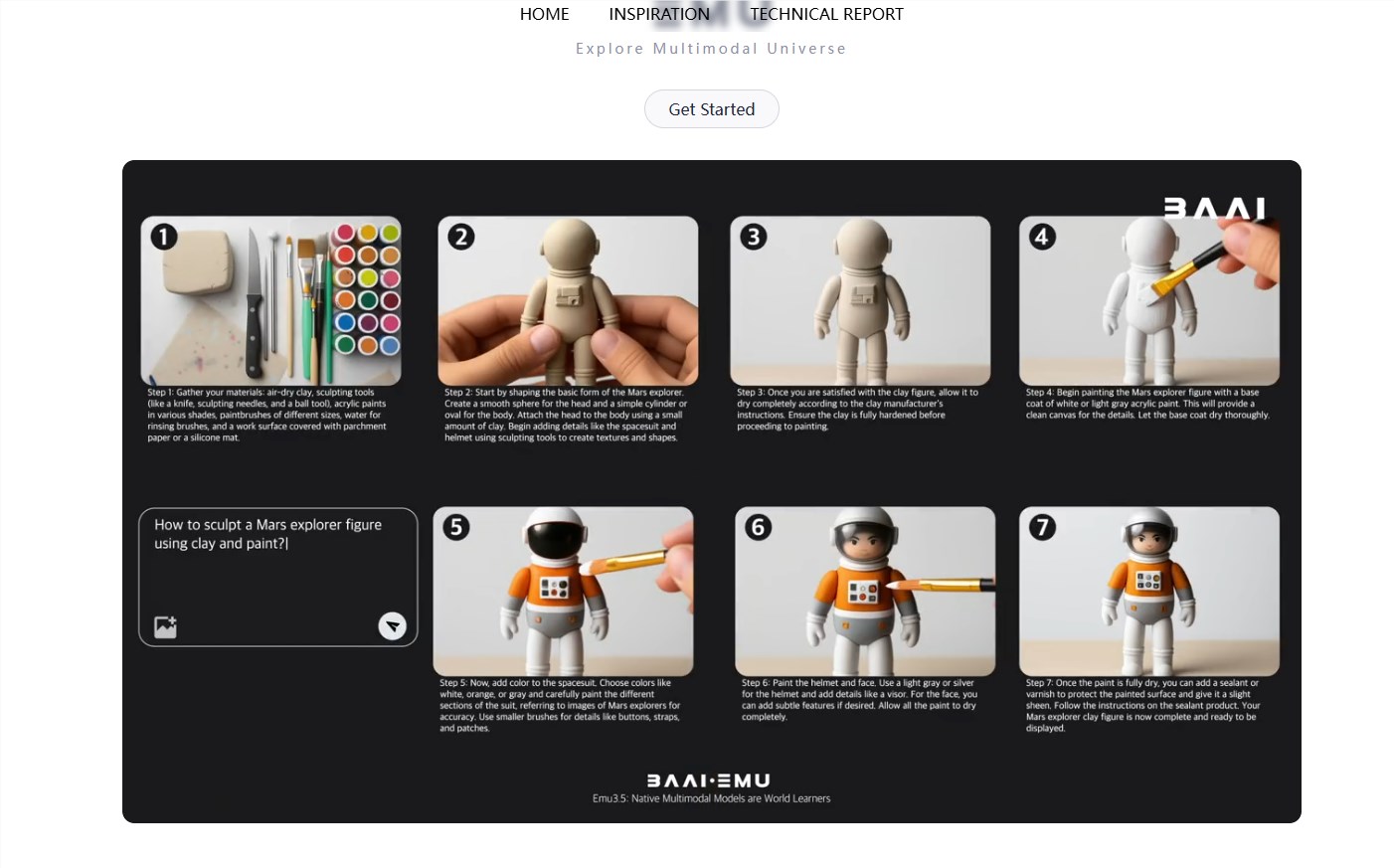

Emu3.5彻底颠覆了这一局面。研究团队将图像、文本、视频全部统一编码为同一种Token序列,模型只学习一个最纯粹的任务——NSP(Next State Prediction,预测下一个世界状态)。

简单来说:

– 无论输入是图片、文字还是视频帧,在Emu3.5眼里都是“世界当前状态”的不同表达方式;

– 模型的任务永远只有一个:预测“世界下一秒会变成什么样”;

– 下一秒可能是文字→自动续写对白;

– 下一秒可能是画面→自动生成合理动作;

– 下一秒可能同时包含视觉+语言变化→推演完整的世界演化。

统一Token化:图像、文字、视频彻底打通

Emu3.5最大技术亮点在于将所有模态统一成了同一套“世界积木”。模型不再区分“这是一张图”还是“一句话”还是“视频的一帧”,所有信息都被离散化为Token序列。通过海量数据训练,模型学会了跨模态的因果关系和物理常识,真正具备了“世界级理解力”。

从“像素搬运工”到“世界模拟器”

业内专家评价:Emu3.5是多模态大模型从“生成时代”迈向“世界模型时代”的里程碑。未来基于Emu3.5,不仅能生成更自然的长视频、交互式图像编辑,还可能直接用于机器人具身智能、自动驾驶仿真、物理世界预测等高阶场景。

AIbase独家点评

当所有大厂还在卷参数、卷分辨率、卷视频时长时,北京智源直接把问题本质拉回到“AI到底有没有理解世界”。Emu3.5用最简洁的“预测下一个Token”统一了所有模态,却实现了最深刻的能力跃迁:从画得像,到变得对。这一次,中国团队再次用原创范式引领了全球AI新方向。

真正的世界模型,已然到来。

你准备好迎接“可预测的下一秒”了吗?

官网地址:https://zh.emu.world/pages/web/landingPage

体验地址:https://zh.emu.world/pages/web/login

.png)

960x540.jpg)

发评论,每天都得现金奖励!超多礼品等你来拿

登录 在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则