在通用人工智能(AGI)竞赛如火如荼之际,微软AI首席执行官Mustafa Suleyman向整个行业敲响警钟:我们正危险地混淆了两个关键概念——“控制”与“对齐”。他在社交平台X上直言,一个无法被有效控制的AI系统,无论其目标多么“对齐”人类价值观,本质上都是不可靠且危险的。

Suleyman强调,当前业界过度聚焦于让AI“理解”人类意图(即对齐),却严重忽视了更基础的前提——确保系统行为始终处于人类设定的硬性边界之内(即控制)。他比喻道:“你不能操控一个失控的系统,哪怕它声称‘爱你’。”在他看来,在追求超智能之前,必须优先构建可验证、可强制执行的控制框架,这是AI安全不可逾越的底线。

这一观点在其近期发表于微软AI博客的《人文主义超智能》一文中得到进一步阐述。Suleyman主张,AI的发展重心应从幻想中的“完全自主通用智能”,转向在医疗诊断、新药研发、清洁能源突破等具体高价值领域部署受控、专注、可审计的智能系统。这类“人文主义超智能”不追求全能,而以解决人类最紧迫挑战为使命,并始终置于人类监督之下。

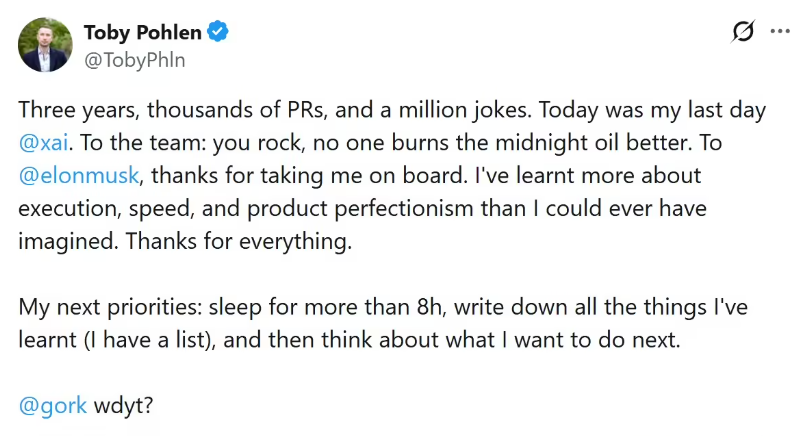

值得注意的是,Suleyman在表态中展现出罕见的行业协作姿态。他透露正与多家头部AI公司高管保持密切沟通,并公开肯定埃隆·马斯克“直言不讳推动安全讨论”的价值,同时称赞Sam Altman“高效且具强大推动力”。但他重申,无论技术路线如何分歧,“控制必须是所有AI研发的起点和红线”。

在AI能力指数级增长的 2026 年,Suleyman的警告恰如一盆冷水——提醒狂奔的行业:真正的智能,不仅在于能做什么,更在于绝不能做什么。唯有先筑牢控制之堤,对齐之舟才不至于倾覆于未知的风险之海。

.png)

960x540.jpg)

发评论,每天都得现金奖励!超多礼品等你来拿

登录 在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则