人工智能公司DeepSeek的研究团队周一宣布,他们发布了一款名为 V3.2-exp 的新实验模型,旨在通过创新的“稀疏注意力”机制,大幅降低长上下文操作的推理成本。这一里程碑式的进展在Hugging Face和GitHub上同步发布,并附有详细的学术论文。

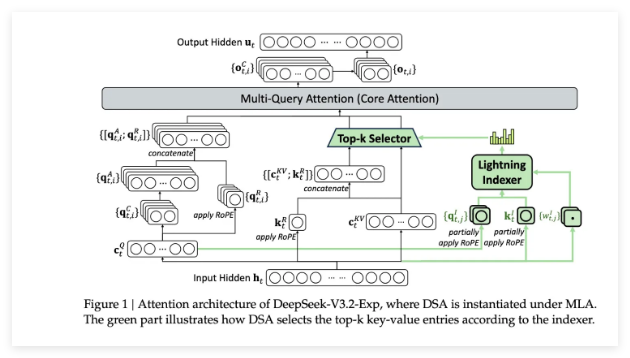

该模型的核心在于其独特的 DeepSeek稀疏注意力机制。这一复杂系统由两部分组成:首先,一个名为“闪电索引器”的模块会对上下文窗口中的特定摘录进行优先级排序;其次,一个独立的“细粒度标记选择系统”会从这些优先摘录中挑选出关键标记,加载到有限的注意力窗口中。这些机制的结合使得稀疏注意力模型能够以较低的服务器负载高效处理长上下文片段。

在初步测试中,新模型展现出显著优势。DeepSeek报告称,在长上下文操作中,简单的API调用成本可降低多达一半。尽管仍需更多第三方测试来验证这些结论,但由于该模型是开放权重并在Hugging Face上免费提供,其真实性能将很快得到行业验证。

DeepSeek的这项突破是近期一系列旨在解决AI推理成本问题的创新之一。推理成本指的是运行已训练AI模型的服务器费用,而非训练费用。与专注于降低训练成本的R1模型不同,此次新模型着重于提高基础Transformer架构的运行效率,为AI应用的普及提供了更经济的解决方案。

DeepSeek在今年的AI热潮中备受瞩目。其早前发布的R1模型以低成本强化学习训练方法引发关注,而此次的稀疏注意力方法虽然可能不会像R1那样引发轰动,但它为全球AI供应商提供了宝贵的经验,有助于共同降低AI服务的运营成本。

.png)

发评论,每天都得现金奖励!超多礼品等你来拿

登录 在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则