9月1日,美团正式推出了 LongCat-Flash 系列模型,并在近期开源了 LongCat-Flash-Chat 和 LongCat-Flash-Thinking 两大版本,吸引了众多开发者的关注。今天,LongCat 团队宣布推出全新家族成员 ——LongCat-Flash-Omni,这款模型在原有基础上实现了多项技术创新,标志着全模态实时交互的新时代。

LongCat-Flash-Omni 基于 LongCat-Flash 系列的高效架构设计,采用了最新的 Shortcut-Connected MoE(ScMoE)技术,集成了高效的多模态感知模块和语音重建模块。尽管该模型总参数高达5600亿(激活参数270亿),依然能够提供低延迟的实时音视频交互能力。这一突破为开发者提供了更加高效的多模态应用场景解决方案。

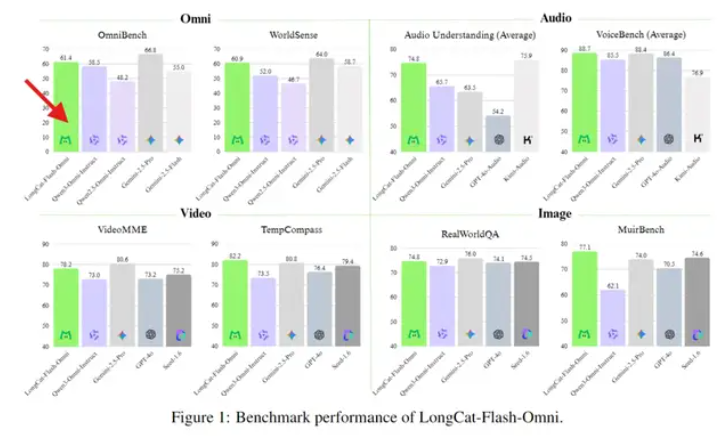

根据综合评估结果,LongCat-Flash-Omni 在全模态基准测试中表现优异,达到了开源最先进水平(SOTA)。该模型在文本、图像、视频理解及语音感知与生成等关键单模态任务中均展现出强大的竞争力,实现了 “全模态不降智” 的目标。

LongCat-Flash-Omni 采用了一体化的全模态架构,整合了离线多模态理解与实时音视频交互能力。其设计理念为完全端到端,使用视觉与音频编码器作为多模态感知器,能够直接生成文本与语音 token,并通过轻量级音频解码器实现自然语音波形的重建,确保低延迟的实时交互。

此外,该模型引入了渐进式早期多模融合训练策略,以应对全模态模型训练中不同模态数据分布的异质性。这一策略确保了各模态之间的有效协同,推动了模型整体性能的提升。

在具体性能测试中,LongCat-Flash-Omni 在多个领域中表现出色,特别是在文本理解和图像理解任务中,其能力不仅未出现衰减,反而实现了显著提升。音频和视频处理方面,该模型的表现同样突出,尤其是在实时音视频交互的自然度和流畅度方面,领先于许多开源模型。

LongCat 团队还为用户提供了全新的体验渠道,用户可通过官网体验图片、文件上传和语音通话功能。同时,LongCat 官方 App 现已发布,支持联网搜索和语音通话,未来将推出视频通话功能。

Hugging Face:

https://huggingface.co/meituan-longcat/LongCat-Flash-Omni

Github:

https://github.com/meituan-longcat/LongCat-Flash-Omni

.png)

960x540.jpg)

发评论,每天都得现金奖励!超多礼品等你来拿

登录 在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则