芝加哥大学最新发布的一项研究揭示,市面上的人工智能文本检测器在准确率、可靠性和鲁棒性方面存在显著差异。有的工具几乎能完美区分人类与 AI 撰写的文本,而有的则频繁误判,甚至在短文本场景下表现失灵。研究显示,检测器 Pangram 以极高的精度和成本效益,在所有参测系统中表现最优。

研究设计:覆盖六类文本与四款主流大模型

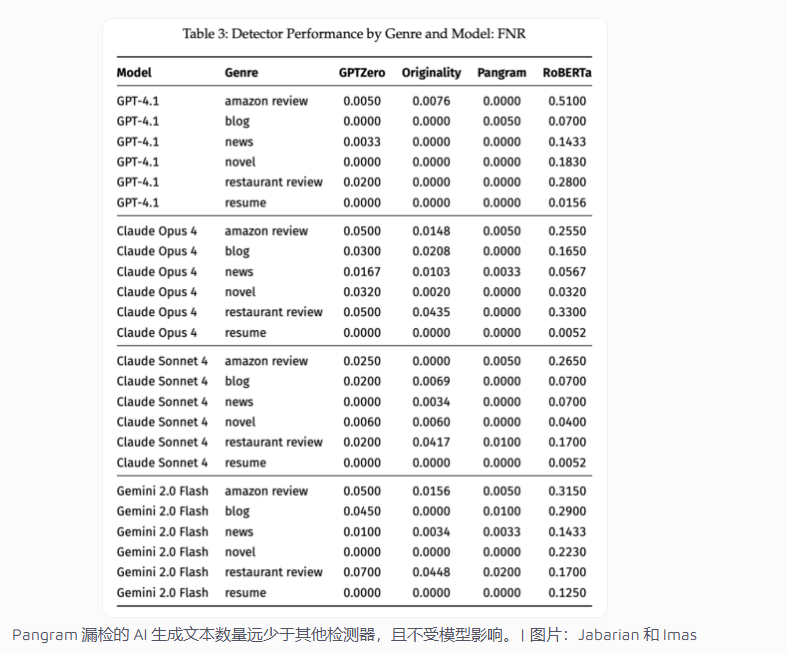

研究团队构建了一个包含 1992篇人类撰写文本 的数据集,涵盖六种类型:亚马逊产品评论、博客文章、新闻报道、小说节选、餐厅评论和简历。同时,他们使用四款主流语言模型 —— GPT-41、Claude Opus4、Claude Sonnet4与 Gemini2.0Flash —— 生成了相应的 AI 样本。

检测性能通过两个核心指标衡量:

误报率(FPR):将人类文本误判为 AI 的概率;

漏报率(FNR):未能检测出 AI 文本的比例。

Pangram 领跑,开源检测器表现最差

结果显示,Pangram 在中长文本中几乎实现 零误判、零漏判。即便是短文本,其错误率也低于0.01,仅在 Gemini2.0Flash 生成的餐厅评论中出现了0.02的轻微误报。

相比之下,OriginalityAI 和 GPTZero 表现位列第二梯队——在长文本中仍具可靠性(误识率维持在0.01以下),但在短样本和“人性化伪装”文本中准确率显著下降。

而基于开源 RoBERTa 模型的检测器则表现最差,将30% 至69% 的人类文本误判为 AI 生成,几乎不具备实际可用性。

检测效果因生成模型而异

研究进一步指出,检测效果与 AI 模型类型密切相关。

Pangram 能准确识别所有四款模型生成的文本,误识率始终低于0.02;

OriginalityAI 对 Gemini2.0Flash 的检测更敏感,但对 Claude 系列 的识别力较弱;

GPTZero 受模型影响较小,但整体精度仍落后于 Pangram。

在小说与简历等长文本中,各检测器的识别率普遍较高,而短评论和简讯类文本则更具挑战性。即便如此,Pangram 的全字母句法算法仍在短文本识别上保持优势。

面对规避工具:Pangram 展现鲁棒性

为测试抗干扰能力,研究人员使用了 StealthGPT——一种旨在让 AI 文本更难被识别的规避工具。结果显示,Pangram 的识别性能几乎未受影响,而其他检测器则准确率大幅下降。

在少于50个单词的短文本场景中,Pangram 的可靠性最高,OriginalityAI 经常拒绝检测,GPTZero 错误率显著高于 Pangram。

成本与策略控制:Pangram 更具实用性

研究还计算了检测成本:Pangram 每正确识别一段 AI 文本的平均成本仅为 0.0228美元,约为 OriginalityAI 的一半、GPTZero 的三分之一。

此外,团队引入了“策略上限(Policy Cap)”概念——允许机构设定最大可接受误报率(如0.5%),系统则自动校准检测器以满足这一阈值。

在这一标准下,Pangram 是唯一能在0.5% 误报率上限下保持高准确率的检测器,而其他检测器的性能均明显退化。

研究启示:检测器与模型的“军备竞赛”

研究人员指出,这场对抗仍处于早期阶段。随着新一代生成模型与“隐身”工具的不断演进,AI 检测领域将迎来一场持续的技术军备竞赛。

他们建议机构应定期进行 检测器“压力测试”式审计,以确保系统跟上生成式 AI 的发展速度。

此外,研究强调了检测器在现实应用中的敏感性:AI 可以在辅助创作中发挥作用,但在教育、求职或评价等领域中替代人类原创,则可能引发伦理与真实性争议。

背景与行业反思

过去,多项研究曾质疑 AI 检测器的可靠性。OpenAI 曾短暂推出官方检测工具,但因准确率低下而撤回,至今未发布新版。研究人员推测,OpenAI 或许并不急于让 ChatGPT 输出易被识别,因为学生等核心用户群可能因此减少使用。

这项芝加哥大学的研究因此被视为 迄今最系统、最量化的 AI 检测评估之一,不仅揭示了不同检测器间的巨大差距,也为机构在学术诚信、内容审核等领域选择检测方案提供了实证参考。

.png)

960x540.jpg)

发评论,每天都得现金奖励!超多礼品等你来拿

登录 在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则